在一个有趣的实验,涉及修改版本的经典游戏俄罗斯方块研究人员发现,深入了解分配不公平的AI和人类社会动力学响应的影响。

这项研究,由康奈尔大学的安Bowers计算与信息科学学院,揭示了个体的认知和行为影响人类或分配决策人工智能。

分配决策

副教授马尔特•荣格领导这项研究探索人际关系影响分配决策,在公平算法研究中经常被忽略的一个区域。

虽然大多数研究关注算法或决策本身,容格和他的团队钻研这些决定的社会后果。

“我们开始看到很多人工智能决策的情况下应该如何分配资源的人,”解释了荣格。

“我们想彼此了解,影响着人们的感知方式和对待对方。我们看到越来越多的证据表明,机器惹我们相互影响的方式。”

休斯顿Claure,第一作者的研究论文题为“机器分配行为的社会后果:公平、人际认知,和性能,”解释说,先前的研究涉及到机器人的分配决定让他们进一步探索个人如何应对机器的偏好。

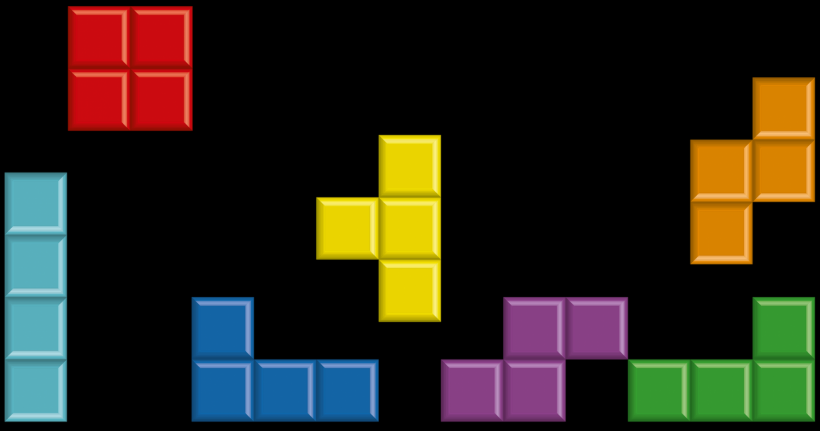

简化他们的调查,团队转向俄罗斯方块,标志性block-stacking视频游戏,一直作为研究理解人类行为和认知的工具。

通过开发一个叫做Co-Tetris双人版,研究员Claure创建了一个平台,参与者合作玩游戏。

Claure采用开源软件创建一个“分配器”系统,决定把球员之间的分布。分配器可以假设一个人或一个人工智能的作用,和参与者被告知分配器的身份。

研究者操纵分配条件,包括场景一个球员获得了90%的,另一个球员获得了10%(称为“少”条件),或同等分裂的50%是维持每个玩家(称为“平等”条件)。

结果显示,人少收到敏锐地意识到对方的优势,而不管分配器是一个人或一个人工智能。

令人惊讶的是,研究人员发现,基于分配器主导地位的看法不同。当一个AI进行分配,玩家获得更少转视对方为主导,而主导观念未受影响当一个人类的分配。

机分配行为

研究者们创造了“机器分配行为”一词来形容的独特行为造成的机器分配决策。

他们还发现,相同配置的转变并不一定转化为更好的游戏和性能。相反,不平等的分配往往导致更好的成绩,作为一个强大的球员接受大部分的块导致整个团队的成功。

Rene Kizilcec,该研究的作者之一,强调的重要性,考虑到人工智能决策个体的长期影响,尤其是在场景连续决策。

作为人工智能工具变得越来越融入日常生活中,如人工智能导师在教育、了解人们如何看待这些系统的能力和公平性是至关重要的。

这项研究开辟了新的途径,研究人工智能决策之间错综复杂的关系,人类的感知、社会动态。

通过调查不公平分配的影响在一个熟悉的和迷人的背景就像俄罗斯方块,研究人员阐明AI-human交互的复杂性,需要进一步在这个领域探索。

这项研究的发现发表电脑在人类行为。

相关文章:高盛(Goldman Sachs)介绍AI-powered社交媒体初创公司“露”