Deepfake视频已经在过去的几年里,一些一直在寻找一些乐趣通过操纵影视场景扮演了不同的角色,但这种操纵真实画面通过人工智能也可能非常危险,所以Deepfake探测器非常有用在核实和修改视频。

然而,现在发现这样的工具可以被打败,根据加州大学的计算机科学家,圣地亚哥。

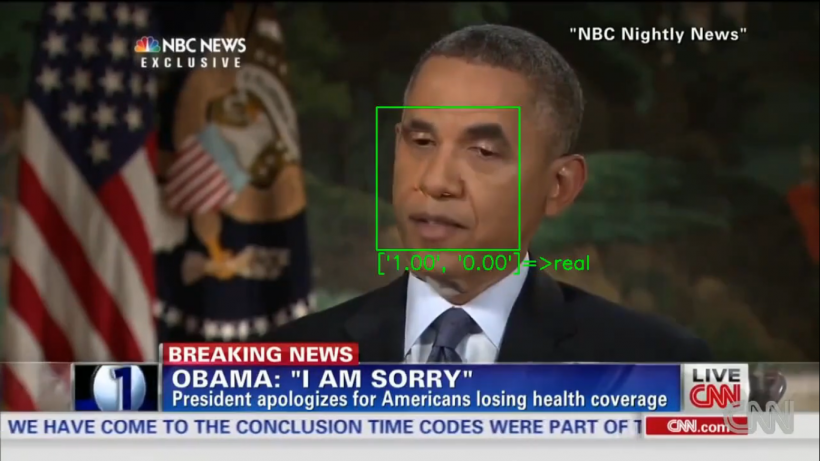

Deepfake探测器通常可以检测假视频通过眨眼等面部特征和行为。

使用“敌对的例子”

在一个报告News18,deepfake探测器可以被添加输入称为“对抗的例子,”略有操纵输入,每个视频帧。

敌对的例子导致人工系统,如机器学习模型犯错误,认为deepfaked视频从来没有感动,根据加州大学圣地亚哥分校的科学家,攻击仍然可以工作尽管假视频压缩,它应该能够删除错误的功能。

基本上,从假冒伪劣探测器可以确定真正的视频通过专注于面部特征,如眼球运动,一般差复制的操作视频。

不幸的是,这种方法可能技巧即使是最先进的探测器。

惊人的证据是在去年冬天会议上展示了应用计算机视觉(WACV) 2021年1月5日至1月9日举行,2021年。

阅读更多:专家警告说对Facebook、微软、贝宝的电子邮件:这就是为什么你必须避免

“可能是现实的威胁”

“我们的工作表明,袭击deepfake探测器可能是一个现实的威胁,“Shehzeen Hussain说,加州大学圣地亚哥分校计算机工程博士生WACV论文的第一作者、加州大学圣地亚哥分校的雅各布斯工程学院在线报纸。

“更令人担忧的是,我们证明了这是可能的工艺强劲的对抗deepfakes即使敌人可能不知道内部运作的机器学习模型使用的探测器,”侯赛因进一步说。

据报道,科学家们能够击败即使是最先进的探测器的警惕性,即使没有进入探测器模型注射时对抗的例子。

高的成功率

测试攻击,研究人员创建了两个场景:一个完整的访问器模型,包括分类模型的结构和参数,脸抽汽管道;和另一个他们只能查询机器的地方。

在第一个场景中,科学家们有一个未压缩的视频中99%的成功率为84.96%,压缩的。

第二个场景中,他们的成功率是86.43%未压缩的视频和78.33%的压缩文件。

科学家们说这是第一次证据已经表明探测器可以被打败。

,纸背后的科学家鼓励改善培训的软件更好的检测等操作,建议这种方法类似于他们所谓的对抗训练,在一个自适应对手的不断生成新的deepfakes,同时探测器继续学习检测操纵样本。

他们也拒绝透露他们使用的密码,以免被敌对方。

相关文章:谨防TikTok假股票,财务建议!如何避免被愚弄;最好的顾问网站

这篇文章是由科技时代万博体育登录首页

作者:Nhx Tingson